RESUMO

O presente trabalho tem por objetivo expor a utilização da solução robótica (Inteligência Artificial – IA) para melhorar a performance do Poder Judiciário em termos de desempenho e resultado, analisando, assim, o caso particular dos Estados Unidos, que se utiliza do sistema COMPAS (Correctional Offender Management Profiling for Alternative Sanctions)[2]. No entanto, apesar dos significativos avanços observados após a implementação do software, fora percebido que o sistema apresentou análises tendenciosas e racistas que comprometeram o propósito inicial para o qual foi criado. Sob essa perspectiva, este artigo busca compreender o problema no que diz respeito ao mapeamento das ameaças e oportunidades de se utilizar soluções tecnológicas dessa natureza, em um contexto de aplicabilidade de processos automatizados de auxílio à decisão no Brasil, utilizando, para isso, da análise SWOT (Strengths, Weaknesses, Opportunities and Threats)[3] a qual irá identificar as forças e fraquezas, além de fatores internos e externos pertinentes ao processo de desenvolvimento e aplicação da solução. A hipótese do trabalho parte da ideia de que a utilização dos algoritmos utilizados no COMPAS, de forma mais justa e transparente, somado à uma supervisão contínua por parte de equipes com pluralidade e diversidade de valores, crenças e um profundo respeito aos ideais democráticos republicanos, possibilitaria uma análise pautada na realidade desejada e na justiça. Para tanto, o método aplicado é o da pesquisa exploratória, através de recursos como livros, legislação, textos – principalmente artigos científicos –como o estudo feito na ProPublica e da obra de Pierre Lévy.

Palavras-chave: Inteligência Artificial. Racistas. Algoritmos. COMPAS. Poder Judiciário.

ABSTRACT

The present work aims to expose the use of a robotic solution (Artificial Intelligence) to improve the performance of the Judiciary, in terms of performance and results, analyzing the particular case of the United States, through the use of the COMPAS system (Correctional Offender Management Profiling for Alternative Sanctions). However, despite the significant advances observed after the implementation of the software, it was perceived that the system presented biased and racist analyzes that compromised the initial purpose for which it was created. From this perspective, this article seeks to understand the problem regarding the mapping of threats and opportunities to use technological solutions of this nature, in a context of applicability of automated decision support processes in Brazil, using SWOT analysis (Strengths, Weaknesses, Opportunities and Threats) which will identify the strengths and weaknesses, as well as internal and external factors pertinent to the process of developing and applying the solution. The hypothesis of the work starts from the idea that the use of the algorithms used in COMPAS in a fairer and transparent way, added to a continuous supervision by teams with plurality and diversity of values, beliefs and a deep respect for republican democratic values, would allow an analysis based on the desired reality and justice. Therefore, the method applied is exploratory research, using resources such as books, legislation, texts – mainly scientific articles – from the study done at ProPublica and the work of Pierre Lévy.

Keywords: Artificial intelligence. Racists. Algorithms. COMPAS. Judicial Power.

1 INTRODUÇÃO

O mundo contemporâneo assiste a um processo de mudanças transformadoras e disruptivas moldadas e aceleradas pela tecnociência. O Poder Judiciário não foge à regra, instado a aprimorar sua performance em termos qualitativo e quantitativo, busca, além disso, uma celeridade processual capaz de atender aos anseios da população por um Direito mais acessível, ágil e justo. Nesse sentido, as soluções robóticas, com Inteligência Artificial (IA), em especial, têm gerado resultados e elevada expectativa em sua utilização e massificação. Todavia também têm apresentado, em casos específicos, fragilidades e imperfeições em seus algoritmos, inclusive, com vieses racistas, de forma que questionasse a possibilidade dos preconceitos enrustidos na sociedade se refletirem nessas ferramentas tecnológicas. Diante desse cenário, cabe uma análise mais crítica e interventiva, de natureza ética e regulatória, tanto quanto à eficácia, como no desenvolvimento dessas inovações.

Ora, os robôs, muitas vezes, têm facilitado a tarefa de muitos juristas, proporcionando um aumento na produtividade, na qualidade da informação e otimizando o tempo gasto em serviços repetitivos. Com isso, um novo desafio vem surgindo, buscar tornar o judiciário mais justo e até delegar funções decisórias para as máquinas, podendo criar ferramentas de IA para auxiliar o juiz nas formatações de sentenças e influenciar no cálculo da pena, com predições feitas por algoritmos sobre os acusados. Seria uma ficção ou uma realidade? Utopia ou distopia? Já que, falar de total imparcialidade, é fugir da veracidade, sabendo que o ser humano é naturalmente parcial, e, a matemática também poderá ser, caso não se tenha os cuidados necessários. Surge a questão: O que nos aproximará mais da Justiça ideal, humanos ou máquinas? Ou ambos?

Nesse trabalho, para que se responda esse questionamento, o sistema de IA do Estados Unidos, chamado COMPAS, foi ponto principal de análise, baseado no artigo realizado pela ProPublica em 2016, a qual produz jornalismo investigativo de interesse público em Nova York. Na ocasião, foi estudado o funcionamento do “algoritmo de reincidência” do sistema, analisando as perguntas que o alimentavam e estimavam (prediziam) os graus de reincidência dos réus, em cada caso. Já na avaliação comparativa, percebeu-se um nível de racismo que contaminou a Inteligência Artificial, além de preconceitos geográficos e sociais, evidenciando que, possivelmente, a qualidade dos dados e das formulações que alimentavam o algoritmo de decisão terminaram por induzir à tecnologia de inteligência artificial ao erro (LARSON; MATTU; KIRCHNER; ANGWIN, 2016, p. 2-3).

Nessa linha, o presente trabalho, fundamentado no método de pesquisa exploratória, tem como finalidade analisar e questionar os vieses preconceituosos que as máquinas podem incorporar, assim como buscar soluções para implementação de um sistema análogo ao COMPAS no Brasil, sem que haja desrespeito aos direitos fundamentais da Constituição Federal de 1988, utilizando-se, para tanto, de recursos como livros, leis, textos e, principalmente, artigos.

Com esse cenário inovador e diante dos seus desdobramentos, o filósofo Pierre Lévy, um otimista em relação à utilização das tecnologias no mundo, traz também questionamentos imprescindíveis, como quem detém o privilégio de saber qual rumo tomar em relação às tecnologias. Desta forma, o autor aduz que ninguém decidirá isso de maneira individual, mas apenas juntos, a sociedade tomará a consciência necessária, pois só o coletivo possui o conhecimento absoluto. Assim, segundo Lévy (2015, p.173), o conhecimento absoluto não vem de uma instituição particular, de nenhuma disciplina ou grupo, muito menos de uma pessoa, portanto, o conhecimento absoluto é aquele que as pessoas constroem juntas, enquanto humanidade, gerando uma inteligência coletiva.

2 TECNOLOGIAS DIGITAIS NO PODER JUDICIÁRIO

A Revolução tecnocientífica tem acelerado e transformado o mundo e, particularmente, impactado os governos, as instituições públicas e suas formas de gerir. Esse fenômeno pós-moderno atua tanto no sentido de pressionar por mais eficiência, transparência e ética, como cria oportunidades de aprimorar e até redesenhar a governança pública. Micklethwait e Wooldridge (2015, p. 13), ao abordarem a crise de credibilidade do Estado contemporâneo, em sua obra “A quarta revolução”, sinalizam também a perspectiva de aperfeiçoar a qualidade, a temporalidade e fluidez das respostas e entregas dos paramentos estatais, estando tudo isso inserido em um contexto de pressão em função da escassez de recursos. E, em parte também, “pela lógica da competição crescente entre os Estados nacionais, e pela oportunidade de fazer as coisas de um jeito melhor” (MICKLETHWAIT; WOOLDRIDGE, 2015, p. 13).

Em um cenário dessa natureza, se por um lado o Poder Judiciário é afetado em todas as suas frentes, por outro, cria-se um imenso espaço para que as tecnologias comecem a se conectar, cada vez mais, com o mundo do Direito, suprindo suas falhas, acelerando seus atos e até auxiliando nas tomadas de decisões. Thémis[4], consultando ou se utilizando de um robô, já não é mais uma visão de ficção científica, é realidade pura. Além disso, é ilusório se opor, como um ludita[5], ao uso dessas novas tecnologias como a Inteligência Artificial (IA), Internet das Coisas[6], Big Data[7], entre outras, visto que elas já fazem parte da vida moderna e, a grande tendência é que seu alcance só aumente. Da mesma forma, é de extrema importância introduzir, nos ambientes de criação e desenvolvimento, visões éticas, pluralistas e valores humanistas.

Neste sentido, apontam Nunes e Marques (2018, p.1) que o Poder Judiciário vive uma grande “virada tecnológica” diante de várias inovações no seu funcionamento. Dentre as inúmeras possibilidades de uso de tecnologia digital, aquelas que se utilizam de sistemas com Inteligência Artificial embarcada permitem diversos benefícios, como o auxílio à tomada de decisões através de ferramentas que reúnem sentenças e jurisprudências, trazendo celeridade para tarefas repetitivas. Contudo, surgem alguns questionamentos, sendo necessário que essas ferramentas sejam efetivadas com cautela e acompanhamento para que não se dissociem dos princípios que regem a Constituição Federal, a moral e a ética. A Inteligência Artificial vem quebrando paradigmas na cultura jurídica e modificando as práticas dos seus profissionais, entretanto, apesar de ser uma revolução irrefreável, é preciso acompanhá-la com olhos multifuncionais, com os quais se enxerguem o mundo como um todo, e o Direito nele.

As máquinas já possuem um grande papel na transformação do Direito, como a criação de métodos de buscas para análise de documentação jurídica, armazenando e consultando dados relevantes para os processos. As soluções de big data processam essas informações com mais velocidade e em uma escala bem ampla. Com todos esses conjuntos de dados e informações tratados e analisados, a Inteligência Artificial passa a predizer decisões, analisando os seus riscos e benefícios. Dessa forma, é notória a serventia desses sistemas tecnológicos, melhorando a qualidade da justiça e diminuindo os custos que sofriam pela demora e tempo gasto em coisas que, atualmente, uma máquina soluciona com mais agilidade e, por vezes, com mais qualidade, em função de sua capacidade de processamento computacional e uso de IA com NPL (Natural Language Processing[8]).

Esta é, portanto, uma era em que os robôs vêm se incorporando ao aparato estatal do Judiciário para contribuir e, até mesmo substituir determinadas tarefas humanas. Em alguns casos, portanto, essa transformação estaria trazendo mais justeza? A resposta desse questionamento envolve diversos fatores e rodeiam o mundo e, grande é o desgaste das instituições a fim de decifrar esse conflito, buscando formas de tornar essa resposta positiva e minimizar a crise política, humanitária e jurídica em que vivemos.

2.1 O DESGASTE DAS INSTITUIÇÕES PÚBLICAS

A sociedade está cada vez mais crítica e exigente com relação às entregas (serviços e produtos) oferecidos/prestados pelas instituições públicas. Sob pressão e desconfiança, instaurou-se uma crise de credibilidade e desesperança com o Estado e com as lideranças políticas. Razão, assim parece, do surgimento de movimentos populistas, com vieses autoritários e nacionalistas em muitos países. Segundo Micklethwait e Wooldridge (2015, p. 13), “o principal desafio político da próxima década será consertar o governo”.

Assim, o Estado vive uma grande descrença por parte dos cidadãos, conforme sua falta de consonância com as expectativas geradas para proporcionar um melhor padrão de vida. Tudo isso causa um desgaste nas instituições públicas e, é preciso que o Estado se reinvente. Dessa forma, as novas tecnologias e a Quarta Revolução entram em cena, oferecendo a chance de modernizar instituições que estão sobrecarregadas de atribuições (MICKLETHWAIT, WOOLDRIDGE, 2015, p.13), e necessitando de soluções rápidas, práticas e eficientes.

De acordo com o site de notícias O cafezinho (2019), no contexto nacional, a pesquisa do IBOPE de 2019, mostra que apenas 55% dos brasileiros confiam no Poder Judiciário, alegando que o sistema nacional não tem mais capacidade para atender as demandas da sociedade. O filósofo Christoph Lumer (2005, p.30) em sua obra Enciclopédia da Filosofia, dispõe que o conceito de Justiça é abstrato e trata de um estado ideal de interação social em que há um equilíbrio, que por si só, deve ser razoável e imparcial entre os interesses, riquezas e oportunidades entre as pessoas envolvidas em determinado grupo social. Dessa forma, o sonho que muitos nutriam acerca do Poder Judiciário tem gerado decepções, visto que tais anseios da população não são devidamente atendidos.

Um levantamento feito pela Fundação Getúlio Vargas (FGV, 2020), em parceria com a Associação dos magistrados do Brasil (AMB) e o Instituto de Pesquisas Sociais, Políticas e Econômicas (Ipespe), no ano de 2020, relata que o grau de confiança da população no Judiciário é de 52%, e que 64% aponta como problema a lentidão e burocracia que vem do sistema, 28% indica que favorece mais quem tem dinheiro e poder, e 20% dos brasileiros estabelece que uma grande dificuldade está na ineficiência.

Além de tudo, o estudo global Edelman Trust Barometer (2020), conforme citado pela Edelman Brasil (2020), retrata que, no Brasil, nenhuma instituição possui confiança total, assim como nenhuma é considerada ética e competente em conjunto. Além disso, revela tal pesquisa que “as ONGs são consideradas éticas; as Empresas são consideradas competentes e o Governo e a Mídia, nem competentes, nem éticos”.

Tendo em vista essas diversas problemáticas e descrenças, surgem as soluções robóticas, guiadas pela Inteligência Artificial, que devem ser objetos de análise e reflexões, para que sejam recepcionadas pelos brasileiros e aprimore o sistema judiciário, podendo fazer os processos serem mais céleres, mais acessíveis, mais imparciais, e, principalmente, mais éticos. A grande discussão é como introduzi-los da melhor maneira possível e voltar a atender os anseios da sociedade, recuperar a confiança nesta instituição tão importante e crucial para o Brasil. A Revolução 4.0 já tem invadido a vida de muitos e principalmente do Judiciário, sendo necessário acompanhá-la com princípios éticos e humanísticos.

2.2 REVOLUÇÃO 4.0 E A INTELIGÊNCIA ARTIFICIAL

Revolucionar, segundo o Dicionário Houaiss de Língua Portuguesa (2004, p. 648), significa “provocar mudanças significativas e estruturais”. A Primeira Revolução Industrial se iniciou na Europa e aconteceu entre os anos de 1760 a 1840, com a produção mecanizada e o uso de energia de máquinas a vapor, foi a primeira referência na área de produção de grande escala, substituindo o trabalho artesanal pelo assalariado. Na Segunda Revolução Industrial (1850-1945) houve o desenvolvimento de indústrias química, elétrica, de petróleo e aço, e o progresso dos meios de transporte e comunicação. A Terceira Revolução Industrial verificou-se nos anos de 1950 a 2010, foi marcada por grandes avanços na ciência, e houve o surgimento de novas tecnologias, inclusive, da internet e microcomputadores.

A Revolução 4.0 teve seu conceito desenvolvido pelo Alemão Klaus Schwab (2016, p.17), o qual mostra a aceleração de soluções transformando cada vez mais os modelos econômicos, sociais, culturais, políticos e até a forma como as pessoas se comportam. O conceito está ligado ao modelo empresarial que tinha como objetivo fundir todas as tecnologias disponíveis e gerar produtividade e conhecimento.

A intenção inicial alemã era de aumentar a produtividade de sua manufatura a partir de modelos “disruptivos”, termo criado pelo professor de Harvard Clayton Christensen, o qual significa uma transformação em um setor existente, introduzindo simplicidade, conveniência e acessibilidade, onde a complexidade e o alto custo eram a norma, acabam provocando uma ruptura com os padrões, modelos ou tecnologias já existentes. A velocidade fora dos padrões e os seus impactos trazem o surgimento de cenários muito distintos, uma espécie de novo mundo vindo como uma onda de novas descobertas, com diversas oportunidades, mas também muitos riscos. Assim, consoante com o já ocorrido nas primeiras revoluções industriais, recorda Harari (2016, p. 276), que as “máquinas a vapor, ferrovias, telégrafos e eletricidade criaram problemas inéditos, assim como oportunidades sem precedentes”. Para Schwab (2016, p. 16), a grande diferença entre a quarta revolução Industrial e as anteriores é a “fusão dessas tecnologias e a interação entre os domínios físicos, digitais e biológicos”.

Com essa fusão de tecnologias e interações humanas, os custos são reduzidos, a produtividade é aumentada, e há uma promessa de melhoria de qualidade. Assim, tem-se entre os cenários possíveis, um utópico, no qual há uma busca pelo novo, da tecnologia como ferramenta propulsora para evolução, como aprimoramento da humanidade e, segundo o Filósofo e Historiador Leandro Karnal (2017), a utopia sempre teve uma função essencial, corrigir o tempo atual. Além do mundo distópico, mais negativista e no qual a vida só de alguns melhorará com a tecnologia e acabará agravando as desigualdades. O grande desafio é achar um equilíbrio entre esses dois mundos para que sejam avaliados e introduzidos da melhor maneira.

As relações humanas são atingidas diretamente pela tecnologia digital e este cenário tem produzido uma série de conflitos complexos, o que requer a atuação imediata do Direito, o qual precisa acompanhar esta inovação e apresentar soluções jurídicas e normativas que garantam a segurança e o exercício dos seus direitos (PIAIA; COSTA; WILLERS, 2019, p.128).

As tecnologias transformam o ritmo anterior das coisas e potencializam oportunidades por atuarem em todos os campos da vida. Neste sentido, nunca antes foi tão necessário integrar e ser cuidadoso no uso das potencialidades, sutilezas e poder transformador da justiça, tecnologia e ética, sem jamais dissociá-los, pois, na atualidade se faz necessária a criação e o desenvolvimento de ferramentas com visão multidisciplinar, para que a velocidade das inovações não as desvirtuem, desligando-as dos valores e, para que não se perca o olhar humanitário, ou seja, que conclua por uma decisão mais acertada e benigna para a sociedade/réu. Por isso, quando se trata de justiça, trata-se também da celeridade processual, dos direitos humanos resguardados e da equidade do sistema judicial.

Segundo Piaia, Costa e Willers (2019, p. 129), a quarta revolução tem apresentado reflexos no Poder Judiciário através do Processo Judicial Eletrônico (PJE), que transformou todas as peças em virtuais após a promulgação da Lei n° 11.419 de dezembro de 2006, que introduziu a informatização do processo judicial. Além disso, as ferramentas de Inteligência Artificial já estão dominando o Direito, uma vez que muitos tribunais do Brasil já possuem algum tipo de robô para auxiliá-los em suas tarefas, como trabalhos repetitivos e até sugestões de sentenças e indicações de jurisprudência. Assim, uma nova Era, antes tão distante da realidade e considerada uma fantasia, está mais presente do que nunca e mudando o mundo.

De acordo com Nunes e Marques (2018, p. 3), Inteligência Artificial é um programa multidisciplinar que busca desenvolver autômatos para solucionar conflitos de uma forma bem melhor que os humanos. A IA possui conhecimento de várias disciplinas que auxiliam no fim da sua aplicação desejada, usando de ciência da computação, matemática (lógica, otimização, análise de probabilidades) e da área que se planeja aplicar. Os algoritmos que as sustentam são conjuntos de regras e operações estabelecidos para solucionar determinado problema, que se tratam, portanto, do propulsor do sistema de IA, analisando banco de dados e dando suas respostas com base neles. Agora, as máquinas estão sendo programadas para aprenderem sozinhas, ao invés de programar as regras, é possível implementar algoritmos que façam com que as próprias máquinas as descubram, um verdadeiro aprendizado de máquinas (machine learning).

No mundo das IAs encontram-se várias espécies como o Machine Learning, Deep learning[9] e o NLP (natural language processing)[10], os quais, nos dizeres de Fabio Gandour (2020), precisam ser alimentados com regimentos e regras operacionais, dados e informações conferidas e aprovadas por um grupo selecionado.

O machine learning é um aprendizado de máquina que têm softwares de análise de estatística e análise preditiva, usados para encontrar padrões com base em dados antes observados, necessitando do trabalho de cientistas para pré-processar os dados e entregar aos algoritmos para que se encontrem padrões. Já o deep learning faz uma aprendizagem mais profunda, tendo o machine learning estabelecido os fundamentos para que ele evolua, sendo mais intuitivo e não precisando de tanta intervenção humana como o anterior, que utiliza redes neurais artificiais para melhorar a compreensão da máquina. O NLP, ou processamento de linguagem natural, por sua vez, se dedica a desenvolver a capacidade da linguagem da programação para entender a linguagem natural, ou seja, a linguagem dos seres humanos.

Essas transformações tecnológicas vêm como ferramentas de aperfeiçoamento, e não como mero elemento de substituição da força intelectual de trabalho, apesar de que se torna necessário que os seres humanos se aprofundem nessas inovações para que de fato o seu intuito seja realizado. Segundo McGinnis e Pearce (2014, p. 21), o Direito terá uma maior transparência com a aplicação de tecnologias em seus serviços jurídicos, possibilitando uma maior eficiência e qualidade.

Uma grande questão que rodeia o mundo do Direito é se a máquina, diante de tantas inovações, e até se assemelhando aos trabalhos dos humanos, poderão ter funções decisórias, e como afastar os vieses algorítmicos introduzidos por seus programadores que podem incluir subjetividades negativas. Assim, a ferramenta que será analisada para responder essa questão é o COMPAS, utilizado nos Estados Unidos para auxiliar a fixação da sentença do réu.

3 SISTEMA CORRECTIONAL OFFENDER MANAGEMENT PROFILING FOR ALTERNATIVE SANCTIONS

No Estados Unidos, os algoritmos para análise de reincidência têm sido bastante utilizados pelos juízes, existindo dezenas deles que estão em uso nos tribunais, como afirma Larson, Mattu, Kirchner e Angwin (2016, p.1). Contudo, uma ferramenta tecnológica que tem tido grande destaque é o COMPAS (Perfil Corretivo do Gerenciamento de Infratores para Sanções Alternativas. Tradução livre), a qual ajuda os juízes a fazerem a dosimetria da pena, reportando à Era intrigante das decisões algorítmicas.

O sistema funciona a partir da aplicação de um questionário que, ao ser preenchido, gera um índice de reincidência dos acusados, com uma pontuação de 1 a 10 (baixo risco à alto risco), com previsões de “risco de reincidência” e “risco de reincidência violenta”. Dessa forma, essa classificação serve de base para o resultado gerado pelo algoritmo, em termo de quantitativo da pena.

O algoritmo usado para criar as pontuações de risco é um produto de uma empresa com fins lucrativos, a Northpointe, nos Estados Unidos, que foi fundada em 1989 por Tim Brennan, professor de estatística na Universidade do Colorado, e Dave Wells, que dirigia um programa de correção em Traverse City. Ambos decidiram criar o COMPAS para avaliar as “necessidades criminológicas” que se relacionam com as principais teorias da criminalidade, incluindo “personalidade criminosa”, “isolamento social”, “abuso de substâncias” e “residência/estabilidade”. Essa ferramenta se tornou uma das mais populares usadas nos Estados Unidos e no auxílio em sentenças e pré-julgamentos na justiça criminal (LARSON; MATTU; KIRCHNER; ANGWIN, 2016, p. 9).

O COMPAS é uma inteligência artificial que usa “aprendizado de máquinas”, conhecida como machine learning, e tem a intenção de tornar as decisões judiciais cada vez menos influenciáveis por erros humanos. Importante entender que essa solução de tecnologia digital se utiliza das experiências de sentenciamento do Poder Judiciário, identificando padrões de dosimetria através de correlações e análises de dados e das respostas dos questionários. A partir desses padrões analisados, a máquina vai conseguir fazer determinações e até predições, por variáveis encontradas dentro de todo o seu banco de dados.

3.1 APLICAÇÃO DO COMPAS

Os fabricantes do sistema COMPAS disponibilizaram o questionário utilizado em sua ferramenta para os pesquisadores da ProPublica, tornando-se possível que se analisasse um pouco as suas perguntas e buscasse entender como era seu funcionamento. O questionário é preenchido de acordo com cada réu e, assim, após computar as respostas, será feita uma análise probabilística do potencial de reincidência do acusado, com base em dados de experiência.

As perguntas trazidas para avaliar o acusado no COMPAS possuem questões sobre com que frequência ele fica entediado, se já se sentiu triste com as coisas de sua vida, se ele se torna perigoso quando alguém o deixa com raiva, estabilidade financeira, se ele possui pensamentos criminosos. Porém, também existem perguntas sobre questões externas, como por exemplo, se alguém da família foi preso, se a pessoa vive numa área com alto índice de criminalidade, se tem amigos que fazem parte de gangues, assim como o seu histórico profissional e escolar. Dessa forma, os algoritmos usam as bases de dados que já possuem e os casos anteriores sobre aquela questão e quantificam (estimam), atribuindo um rate à capacidade daquele réu de voltar a cometer um crime futuramente.

Observa-se que, em geral, na elaboração do modelo de IA, os dados são fornecidos, após um processo de seleção ou mineração de dados (data mining), para que seja possível a aprendizagem eficiente do sistema (machine learning), desta forma, a máquina vai analisar as informações que foram submetidas, seguindo instruções implementadas pelos algoritmos, para que busquem padrões e, assim, conseguirem prever um determinado resultado.

Dessa forma, quanto maior a base de dados (Big Data), mais se exigirá da capacidade de processamento das máquinas, por isso, até do ponto de vista quantitativo, é fundamental excluir dados que não ajudam a refinar o modelo nem melhoram os resultados, evitando-se gastos de recursos e tempo desnecessários.

Além disso, a qualidade dos dados é muito mais importante do que a quantidade deles, por isso os programadores (e especialistas) devem selecioná-los com bastante cautela, pois esses dados são apurados de sociedades que possuem muitas desigualdades, exclusões e discriminações (NUNES; MARQUES, 2018, p.5).

Ressalta-se, pois, a necessidade de se ter, nos grupos de desenvolvedores e/ou validadores, pessoas com conhecimento profundo e sensível para atuar de forma crítica no processo de seleção de dados, a despeito das técnicas de mineração de dados inerente à essas ferramentas, o que parece ser uma condição sine qua non para se chegar a resultados satisfatórios.

Muitos juízes dos Estados Unidos têm usado o COMPAS na hora de fazer a dosimetria da pena, com a proposta de que estariam sendo mais imparciais e, consequentemente, mais justos, seguindo essa análise preditiva. Larson, Mattu, Kirchner e Angwin (2016, p. 5), interpretaram a definição da Northpointe de predição, para o caso em estudo, “como uma infração penal que resultou em um registro de prisão e ocorreu após o crime pela qual a pessoa foi pontuada pelo COMPAS”. Na mesma linha, o conceito de Alice Sima (2019) é bastante esclarecedor:

A predição, dentro da imensidão de possibilidades proporcionadas pela junção entre a tecnologia e a matemática, nos permite prever eventos futuros baseados em eventos passados. A realização da predição se dá com o mapeamento de variáveis dentro de tudo o que já ocorreu no objeto analisado. Pega-se uma série de eventos para então cruzar as diferentes ocorrências entre eventos diversos e assim se estabelece uma correlação entre eles.

De acordo com Ellora Thadaney Israni (2017), ex engenheira de software do Facebook, os autores do COMPAS inseriram, nos algoritmos, dados históricos de reincidência, apurando quais fatores fariam o réu ser de risco maior e, logo após, foram identificados padrões que reuniram casos para criar sentenças compatíveis com as tendências existentes.

Para conferir a acurácia do software, as empresas Northpointe e ProPublica utilizaram um modelo de risco proporcional de Cox, o qual permite o controle das taxas de reincidência ao mesmo momento em que se controla o tempo. Larson, Mattu, Kirchner e Angwin (2016, p.10) analisaram 10.314 réus a partir desse método, e concluíram que 63,6% teriam precisão em seu resultado. Já a Northpointe, afirmou que seu limite de confiabilidade era de 68%, apesar de declarar, em seus próprios estudos, que medidas entre 60% e 70% sugeririam precisões preditivas baixas a moderadas. Diante do apontado, é possível observar uma desarmonia entre as pesquisas.

3.2 COMPLICAÇÃO DO SISTEMA

Apesar de ter intenções benéficas para a sociedade, estudos identificaram vieses racistas na aplicação da IA-COMPAS. De acordo com Larson, Mattu, Kirchner e Angwin (2016, p. 2), em uma investigação da ProPublica, a qual é uma organização jornalística sem fins lucrativos dos Estados Unidos, percebeu que os acusados negros têm 45% mais chances de receber uma pontuação alta do que os brancos, ainda que os dois estejam em uma mesma situação, mostrando que, embora o algoritmo utilizado possa não ter um viés racista, os possíveis preconceitos raciais do seu sistema penal e da sociedade podem estar sendo cada vez mais expostos.

Casos em que este problema foi bastante perceptível e que ganhou uma grande visibilidade foram os de Brisha Borden, de 18 anos, acusada de roubar uma scooter Razor e uma bicicleta no valor aproximado de U$ 80,00, tendo apenas um registro de contravenções cometidas quando era menor; e,Vernon Prater, de 41 anos,que roubou ferramentas em uma determinada loja, no valor total de U$ 86,35 e, sendo um criminoso mais experiente, já tendo sido condenado por assalto à mão armada e tentativa de assalto à mão armada, cumprindo cinco anos de prisão. Ocorreu que, ao serem analisados pelo COMPAS, Borden, que é negra, foi classificada como de alto risco, e Prater, que é branco, como de baixo risco. Dois anos depois, quem voltou a cometer um novo crime, para a surpresa do sistema, foi Prater e não Borden, que está cumprindo uma prisão de oito anos por invadir um depósito e roubar milhares de dólares em eletrônicos (LARSON; MATTU; KIRCHNER; ANGWIN, 2016, p. 1-2).

Com a investigação de Larson, Mattu, Kirchner e Angwin (2016, p. 1), foram analisados mais de 10.000 réus criminais no Condado de Broward, Flórida, comparando o que o sistema previu de reincidência e o que realmente ocorreu em 2 anos, tempo escolhido para análise, baseado no estudo da Comissão de Penas dos Estados Unidos (2016), no qual relata que a maioria dos réus que reincidem, fazem isso em um período de 2 anos.

De acordo com Larson, Mattu, Kirchner e Angwin (2016, p. 4), a determinação da raça foi feita baseada nas classificações usadas pelo Gabinete do Xerife do condado de Broward, o qual diferencia entre negros, brancos, hispânicos, asiáticos e nativos americanos.

Com a predição, o algoritmo acertou aproximadamente, para ambos, 59% com réus brancos e 63% para réus negros, entretanto, quando examinado no período de dois anos, há uma discrepância. Os réus negros ganhavam uma pontuação maior em reincidência e não era o que mostrava a realidade comparada com os dados.

A ProPublica ponderou no risco de reincidência geral que os réus negros que não reincidiram em dois anos, ainda assim, tinham mais chances de se classificarem como maior risco em comparação com os brancos, chegando ao número de 45% contra 23%. E, os acusados brancos reincidentes foram classificados como de baixo risco erroneamente mais vezes do que os negros, seguida as porcentagens de 48% contra 28%, respectivamente (LARSON; MATTU; KIRCHNER; ANGWIN, 2016, p. 2). Conforme demonstra a tabela abaixo:

Tabela 1–Risco de reincidência

| Brancos | Negros | |

| Rotulado de maior risco, mas não reincidiu | 23% | 45% |

| Rotulado de baixo risco, mas rescindiu | 48% | 28% |

Fonte: elaborada pela autora com base nos dados da ProPublica, 2016.

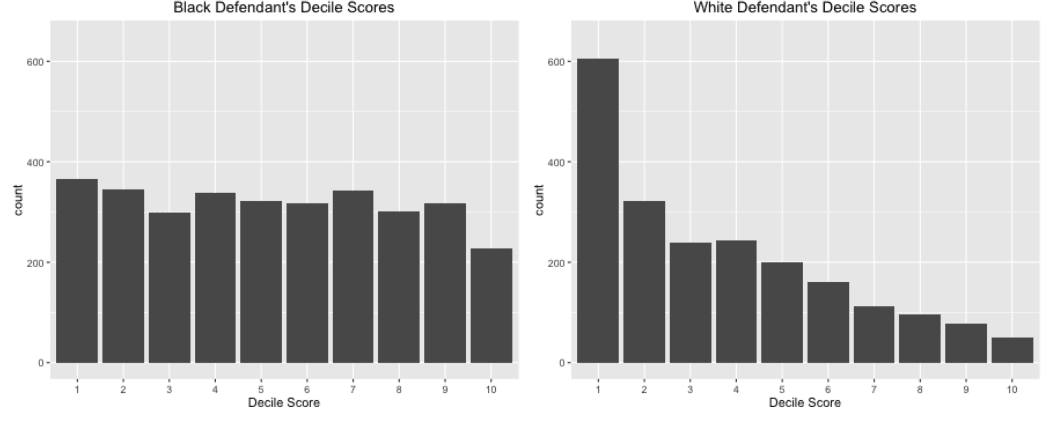

Com isso, Larson, Mattu, Kirchner e Angwin (2016, p. 6), fizeram uma análise inicial examinando o risco de reincidência geral, onde se observou a distribuição das pontuações do COMPAS baseado em 6.172 réus, dentre eles 3.175 negros e 2.103 brancos. O que gerou uma grande surpresa na distribuição de pontos distorcidos quando comparados, os réus brancos eram bem mais pontuados como de menor risco, e os acusados negros estavam pontuados uniformemente. Consoante com os histogramas abaixo:

Figura 1 – Infográficos das pontuações do decil dos réus negros e brancos em reincidência geral

Fonte: Larson, Mattu, Kirchner e Angwin, 2016.

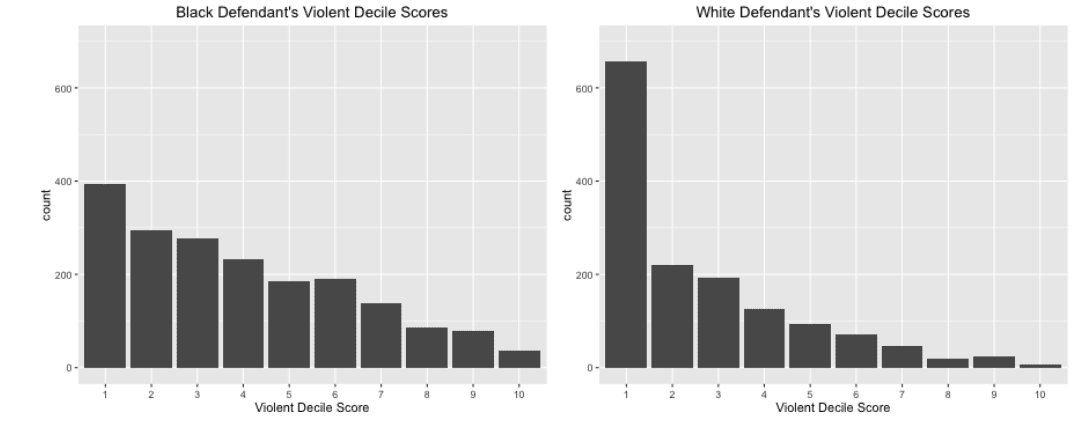

Do mesmo modo, foi feito um histograma do risco de reincidência violenta do COMPAS, os quais demonstraram uma grande disparidade entre negros e brancos, no que tange à distribuição da pontuação. Sendo analisados 4.020 réus, 1.918 negros e 1.459 brancos (LARSON; MATTU; KIRCHNER; ANGWIN, 2016, p. 7). Conforme demonstrado a seguir:

Figura 2 – Infográficos das pontuações do decil dos réus negros e brancos em reincidência violenta

Fonte: Larson, Mattu, Kirchner e Angwin, 2016.

Dessa forma, os dados mostrados podem ter retratado uma realidade que muitos tentam esconder, a saber, o racismo estrutural que subsiste em uma sociedade, nos quais soluções de tecnologia 4.0 podem chegar a intensificar o problema, ao invés de contribuir para uma justiça melhor.

Os algoritmos, já que implementados por seus programadores, e as sentenças que compõem seus bancos de dados, possivelmente podem ter absorvido as fraquezas mentais dos seres humanos e incorporado os vieses de seus formuladores, o que gera uma preocupação revelando disparidades injustificadas, porém, comuns na justiça criminal, as quais estão em constante esforço para minimizá-las e destruí-las.

Mais uma grande crítica a esse sistema é a falta de transparência em seus algoritmos, por serem entendidos como segredos de negócios – algo que precisa ser questionado –, pois, por trás de uma aparente imparcialidade, pode haver processos com obscuridade, tendenciosos e cheios de preconceitos por parte das pessoas que o construíram.

A falta de acesso desses dados para serem entendidos e questionados fomenta a inexistência de paridade entre os réus e as decisões humanas, moldando destinos sem qualquer possibilidade de contestação. Dessa forma, cabe, então, uma reflexão ética de como extinguir as injustiças algorítmicas. O fato é que, possivelmente, na criação do COMPAS, consoante com a fala de Tess Posner, diretora executiva da AI4ALL, uma ONG americana, na Em Tech Digital (2018), faltou diversificar o perfil dos profissionais que trabalham no desenvolvimento desses algoritmos e, de acordo com a ProPublica, apenas os programadores possuem total visibilidade do funcionamento do COMPAS, que são muito menos equipados em relação a fazer justiça, quando comparados aos juízes, os quais possuem a formação jurídica e vários juramentos éticos.

Em particular, com relação à transparência dos algoritmos do COMPAS, no caso de Wisconsin v. Loomis nos EUA, em 2013, no qual Eric Loomis fez um acordo com a Promotoria e admitiu a culpa em dois delitos menos graves (tentativa de fuga de agente de trânsito e condução de veículo sem o consentimento do proprietário). Ao ser analisado pelo COMPAS, o identificaram como um indivíduo de alto risco para a sociedade, sendo fixada, então, uma pena de seis anos de prisão e cinco anos de supervisão estendida, o que o levou a recorrer aos tribunais, pois não foi possível conhecer do funcionamento do sistema para que se elaborasse sua defesa, com a escusa de que seu algoritmo estava resguardado pela propriedade intelectual da empresa fabricante e não poderia ser violado. Contudo, a Suprema Corte dos Estados Unidos se recusou a ouvir o caso, conforme relato da ProPublica (2016).

Consoante com Dierle Nunes e Ana Luiza Marques (2018, p.11), é necessário que esses processos sejam analisados com a perspectiva do devido processo constitucional. Para os autores, “mesmo ferramentas matemáticas, pretensamente imparciais, são imbuídas da subjetividade de seus criadores e diretamente afetadas pela qualidade dos dados fornecidos” (NUNES; MARQUES, 2018, p. 1).

Neste sentido, o artigo 5º, inciso LIV, da Constituição Federal, prevê que “ninguém será privado da liberdade ou de seus bens sem o devido processo legal”, pelo que deve ser conferido a todo indivíduo o direito fundamental a um processo justo, o que assegura também a ampla defesa e o contraditório, que são extremamente violados quando postos diante de sentenças baseadas com algoritmos sem transparência.

Há, ainda, a necessidade de fundamentação das decisões dos juízes encontrada no artigo 93, inciso IX, da Constituição Federal, para que sejam impugnadas, não sendo possível que se utilize de dados que não podem ser explicados e nem entendidos pelo Poder Judiciário. De acordo com Nunes e Marques (2018, p.7), “dados matemáticos opacos e algoritmicamente enviesados” impossibilitam a justa defesa do acusado, dando uma confiança total aos dados matemáticos que seriam supostamente impessoais, imparciais e justos.

Interessa ressaltar que, algumas perguntas do questionário possuem uma discriminação baseada no status demográfico e socioeconômico do indivíduo, será mesmo que se pretende aumentar a penalização de negros por terem atributos em suas vidas que esse algoritmo considera fatores de periculosidade, mesmo que a maioria não seja perigosa?(LARSON; MATTU; KIRCHNER; ANGWIN, 2016, p. 4). Não parece muito justo julgar alguém por questões externas, sobre as quais o indivíduo não possui nenhum controle. Como um robô (IA) analisará de forma justa se aquela pessoa, diante de externalidades, voltará a reincidir em crimes?

Desta forma, pode-se concluir que, mesmo que essa Inteligência Artificial seja feita e implementada com boas intenções, não se pode ignorar os vieses algorítmicos, que, segundo Nunes e Marques (2018, p.6), “ocorrem quando as máquinas se comportam de modos que refletem os valores humanos implícitos envolvidos na programação”.

Diante de todo o exposto, é possível observar que os algoritmos carecem da capacidade humana de se individualizar, o que leva ao questionamento: Será que as experiências não ajudam os juízes a serem melhores aplicadores da lei? Quem definirá o que é verdadeiramente justo? Quem julgará melhor, a máquina ou o ser humano? Ou ambos?

4 A TECNOLOGIA COMO ACELERADORA DO JUDICIÁRIO BRASILEIRO

As ferramentas tecnológicas têm uma perspectiva de melhorar a produtividade e qualidade do Poder Judiciário para se evitar, por exemplo, o que constatou um estudo do Instituto de Pesquisa Econômica Aplicada (Ipea) e do Departamento de Política Penitenciária do Ministério da Justiça (Depen), apontado por Pedro Canário (2014), o qual analisou que “63% dos réus que cumpriram prisão provisória foram condenados a penas privativas de liberdade e 17% foram absolvidos”, concluindo, por isso, que 37% dos réus que estavam em prisão preventiva não foram condenados a penas em que eles precisavam estar devidamente presos, ou seja, comete-se injustiça por inoperância da máquina. Com esta análise, é demonstrado a grande necessidade do Brasil de se ter uma justiça mais célere e mais justa, por consequência, capaz de evitar punições excessivas e desnecessárias, mas também, inibidora de impunidades e até incrementadora de baixa qualidade de vida nos presídios.

No mês de outubro de 2020, o presidente do Supremo Tribunal Federal (STF), ministro Luiz Fux, durante uma webinar organizada pelo Supremo em parceria com a Organização das Nações Unidas (ONU) e o Brazilian Studies Programme[11], um projeto do Centro Latino-Americano (Latin American Centre – LAC) da Universidade de Oxford, anunciou a iniciativa do STF em fundar um laboratório de inovações, o qual agrupará juristas, desenvolvedores, estatísticos e pesquisadores para criarem novas soluções de baixo custo para otimizar os fluxos de trabalho do Tribunal e, assim, tornar o Supremo “a primeira Corte Constitucional 100% digital do planeta, com perfeita integração entre Inteligência Artificial e inteligência humana para o oferecimento on-line de todos os seus serviços”

Pierre Lévy faz uma alerta importante sobre o uso de tecnologias digitais. Segundo o pensador francês, não basta mais que seja só analisado o impacto dessas tecnologias na vida política, econômica e cultural, mas que também se delimite o objetivo em que serão desenvolvidas as redes digitais de comunicação interativa, para que sigam o planejado e sejam sempre corrigidos a fim de que se adeque a realidade e ao seu objetivo, assim, “não entregando seu destino nas mãos de algum mecanismo supostamente inteligente, mas produzindo sistematicamente as ferramentas que lhe permitirão constituir-se em coletivos inteligentes, capazes de se orientar entre os mares tempestuosos da mutação.” (LÉVY, 2015, p.13)

No entanto, questiona-se como fazer uso dessas tecnologias sem os vieses que as levam para um caminho prejudicial e falho, o que causa medo na população e falta de confiança. De acordo com Ellora Israni (THE NEW YORK TIMES, 2017), utilizando-se a transparência e responsabilidade na aplicação de inteligências artificiais como essas, pode-se utilizá-las para o bem. Com uma boa programação, os resultados seriam surpreendentes e poupariam até mais recursos públicos, reservando as penitenciárias para os acusados mais perigosos e viabilizando a reabilitação dos menos propensos a reincidir.

4.1 FERRAMENTAS COM INTELIGÊNCIA ARTIFICIAL NO JUDICIÁRIO BRASILEIRO

Segundo dados do Conselho Nacional de Justiça, conforme citado por Richter (2018), a cada ano do Brasil, 25 milhões de ações são ajuizadas, tendo 74 milhões de casos em curso nas variadas instâncias judiciais. Quase 100 milhões de processos estavam pendentes de julgamento no ano de 2016.

Diante dessa nova onda de tecnologia, muitas IAs já têm espaço no campo jurídico brasileiro e foi possível que diversos dos problemas acima fossem solucionados através de processos inteligentes e inovadores que buscam aumentar a produtividade e eficiência.

Já se tem, inclusive, cases de sucesso no Brasil, a exemplo da Finch Soluções, criada em 2013 em São Paulo, uma plataforma de soluções robóticas que captura e reúne grandes volumes de dados jurídicos com fluxos recorrentes, determinam estratégias, predizem resultados de decisões, otimiza a gestão dos processos, acompanha as citações, analisa a viabilidade de acordos, elabora até tipos de peças jurídicas de acordo com o caso.

Ainda de São Paulo, existe também a Looplex, que se destaca pela automação da produção, sendo uma nova forma do advogado criar petições, contratos, propostas e memorandos em menos tempo e com mais qualidade. Ressalta-se a confecção dos chamados contratos inteligentes, onde a petição calcula o valor das custas e avisa ao cliente por e-mail, cada contrato faz sua própria auditoria.

Mais uma ferramenta de Inteligência Artificial é o Justto que escolhe a melhor estratégia de negociação para solução pacífica de litígios e indica o melhor método para casos concretos, fazendo-o através da reunião automática de dados. Estão presentes também na internet plataformas como o JusBrasil, que reúne um vasto banco de dados de jurisprudências, e o Juridoc, auxiliando na criação de documentos jurídicos, como alguns contratos.

Uma startup Legal Labs[12] criou um software que acelera a tramitação de processos de execução fiscal nas Procuradorias estaduais e municipais de todo o país.Essa “robô-advogada” foi chamada de Dra. Luzia, produzindo em uma velocidade que o ser humano não consegue alcançar, além de diminuindo seus erros.

Muitos escritórios de advocacia vêm usando a plataforma Watson Studio, a qual utiliza de machine learning enfocada no campo de Data Science, sendo capaz de entender, raciocinar e responder diversas perguntas com agilidade, como analisando milhões de artigos em poucos segundos; além disso, propõe decisões que devem ser tomadas, sugerem leitura de artigos e indica até jurisprudências. Com ela, os advogados ainda podem conhecer mais sobre o juiz que está atuando em seu caso e identificar quais decisões foram tomadas por ele em casos semelhantes, ajudando-o a mapear os cenário e se preparar para o que pode acontecer, predizendo os próximos movimentos através dessa grande análise de dados.

O Supremo Tribunal Federal (STF) também possui seu robô com IA, o chamado Victor, o qual executa quatro atividades: Converte imagens e textos no processo digital, separa do começo ao fim, documentos (peça processual, decisão etc.) em todo o acervo do Tribunal, separa e classifica as peças mais utilizadas pelo STF e identifica os temas de repercussão geral de maior reincidência. Trabalhos como esses demandariam de um servidor uma média de 30 minutos, o robô, no entanto, consegue fazer em cinco minutos, aumentando a eficiência na tramitação dos processos e a velocidade na avaliação judicial.

Têm-se também inúmeros avanços na área de Controle Externo, o Tribunal de Contas da União (TCU), por exemplo, com o objetivo de aumentar a eficiência e efetividade do planejamento e execução nas políticas públicas, faz uso de três robôs, desde 2016, chamadas de Mônica, que possibilita ao auditor visualizar dados de órgão contratante, os fornecedores que são mais contratados e os tipos de serviços mais utilizados, de forma ágil e eficiente; Sofia, o sistema de orientação sobre fatos e indícios de irregularidades; e Alice, a que analisa editais de licitações feitos pelos órgãos federais.

O Tribunal de Contas do Estado da Paraíba (TCE-PB), com uma parceria com o Laboratório Analytics da Universidade Federal de Campina Grande, criaram a robô Turmalina, a qual avalia os portais de transparência dos entes federativos paraibanos, seguindo um conjunto de instruções e, após toda sua pesquisa ela monta um relatório de diagnóstico no padrão do TCE. A robô ainda possui um ano de vida e está em fase de testes para sua validação, mas, o seu objetivo é aumentar a transparência, a fiscalização e fortalecer o controle social, além de aumentar a produtividade nos trabalhos dos auditores, com redução expressiva de custos.

Antes, parecia inacreditável e irreal falar que existiriam robôs atuando nesses campos do Direito e cumprindo tarefas nessa velocidade e qualidade, além de facilitando o trabalho de muitos juristas. A Era das Acelerações veio tirar sonhos de papéis e transformar em realidade, despertou a esperança no mundo jurídico, trazendo um novo brilho e vontade de crescer mais e mais.

4.2 SOLUÇÕES PARA IMPLEMENTAR IAS ANÁLOGAS AO COMPAS NO BRASIL

Apesar dessas soluções, em alguns casos apresentarem falhas ou ajudarem a cometer injustiças, como ocorreu com o COMPAS, no qual os algoritmos e a qualidade dos dados foram comprometidos, a interpretação e formulação dos questionários foram enviesadas, como também foi destacada a ausência de uma refinada preocupação nos resultados gerados e os pressupostos escolhidos, é possível e necessário introduzir, nos ambientes de criação e desenvolvimento, visões éticas e valores humanistas capazes de expressar os sentimentos, os anseios e a esperança de um mundo melhor e mais justo.

Uma das soluções para o COMPAS é que seu funcionamento poderia ser detalhado em um documento e publicizado, assim os algoritmos poderiam ser analisados pelos juízes e os especialistas, que são mais equipados para julgar do que os programadores, além do acusado ter acesso aos mesmos, para que se possa afastar as variáveis constitucionalmente inadmissíveis, como raça, gênero e contextos geográficos. Ellora Thadaney Israni (2017, p.1) também expõe que muito do aprendizado dos computadores é ensinado por humanos que, consequentemente, também passam seus preconceitos e valores pessoais. Por isso, a necessidade de uma ação corretiva dos humanos, que se faça com equipes com pluralidade e diversidade de valores, crenças e um profundo respeito aos valores democráticos e republicanos. Principalmente, se for levado em consideração que a escravidão no Brasil só foi abolida há um século e, que muitas feridas desses tempos ainda estão abertas. Se as máquinas não forem constantemente treinadas, com a inserção de critérios éticos e humanistas, elas acabam por voltar para suas supostas determinações iniciais, e afastam-se da realidade e da justiça.

Em um caso de Nova Jersey, nos EUA, foi usado um programa de avaliação de risco conhecido como Avaliação de Segurança Pública, para modificar o sistema de fiança no ano de 2017, reduzindo 16% da população carcerária antes do julgamento. Esse algoritmo também foi utilizado no condado de Lucas, em Ohio, dobrando o número de liberações pré-julgamento sem fiança. Esse programa teve seu funcionamento detalhado em um relatório que foi publicizado, permitindo que os especialistas no assunto verificassem e analisassem se haviam vieses negativos e moralmente permitidos (ISRANI, 2017).

Consoante com Felipe e Perrota (2018, p.12), é necessário que exista uma “moralidade algorítmica” para que o avanço da tecnologia seja saudável para os profissionais do Direito, criando padrões éticos que devem ser seguidos pelos programadores e desenvolvedores de IA afastando os efeitos indesejados. Essa ideia já vem sendo discutida pelo Parlamento Europeu, o qual argumenta que, “na fase de programação ou criação da inteligência artificial, deve-se estabelecer padrões ou princípios gerais relativos ao desenvolvimento da robótica e da inteligência artificial para utilização civil” (FELIPE; PERROTA, 2018, p. 12). O parlamento diz, ainda, que os robôs têm capacidade de alterar o ambiente em que se encontram de forma significativa, por aprenderem com as experiências que eles são postos, e ainda podem tomar decisões independentes dos seres humanos, o que os assimila cada vez mais com os agentes que estarão no seu espaço.

No Brasil, seria possível a criação de um sistema análogo ao COMPAS, mas com seus aprimoramentos e garantindo sua melhor efetividade. Inclusive, estimulando soluções advindas de ambientes colaborativos entre o Poder Público, as Universidades e a iniciativa Privada, as próprias Govtechs, que são startups[13]focadas na área pública, a buscarem soluções em parceria com o Poder Público, no sentido de desenvolver uma IA que auxiliasse na hora da formatação da dosimetria da pena e sua sentença final, inclusive escrevendo a minuta da sentença, através de algoritmos transparentes e com uma equipe que contenha várias áreas de atuação como jurídicas, econômicas, humanísticas e éticas. Um time com uma verdadeira Inteligência Coletiva, conceito dado por Pierre Lévy (2016, p.26):

É uma inteligência distribuída por toda parte, incessantemente valorizada, coordenada em tempo real, que resulta em uma mobilização efetiva das competências. A base e o objetivo da inteligência coletiva são o reconhecimento e o enriquecimento mútuos das pessoas, e não o culto de comunidades fetichizadas ou hipostasiadas. O ideal da inteligência coletiva implica a valorização técnica, econômica, jurídica e humana de uma inteligência distribuída por toda parte, a fim de desencadear uma dinâmica positiva de reconhecimento e mobilização de competências.

Nessa linha, o ministro Luiz Fux (2019), do Supremo Tribunal Federal, avalia que a programação deve ser inteiramente exposta para todos e seria necessário considerar os valores e pressupostos que são inseridos nesses programas, os mecanismos que são incorporados por eles a fim de não enviesar os resultados obtidos, e também esclarecer qual seria a natureza dos dados manipulados para, assim, conseguir o resultado desejado e mais justo.

Ainda, o Parlamento Europeu, em sua resolução de 2017, pleiteou o princípio ético da transparência para a regulação do uso da robótica, possibilitando a fundamentação das decisões tomadas com recursos de IAs que impacte na vida das pessoas, para que sempre seja possível “reduzir a computação realizada por sistemas de IA a uma forma compreensível para os seres humanos”(NUNES; MARQUES, 2018, p.8).

Com todo o exposto, com um bom time de desenvolvimento da IA, com pluralidade de conhecimentos, e com a transparência dos algoritmos, é possível alcançar uma programação ideal.

5 CONSIDERAÇÕES FINAIS

O presente estudo dedicou-se a expor as soluções robóticas para os problemas do Poder Judiciário, dando grande enfoque aos sistemas de Inteligência Artificial para auxílio no sentenciamento criminal e na predição de reincidência.

Inicialmente, foi destacado o porquê da necessidade da implementação dessas tecnologias nesses ambientes jurídicos e como elas já estão impactando o mundo. A tecnociência vem suprindo falhas, diminuindo custos e criando novas oportunidades de aprimorar o Judiciário, destacando-se a grande importância da não dissociação dos princípios constitucionais os quais regem o nosso ordenamento jurídico.

A imprescindibilidade dessas inovações nasce, inclusive, da própria crise de credibilidade que os governos e as instituições vêm sofrendo devido às expectativas da população, que crescem exponencialmente em um contexto de sociedade em rede, em detrimento de uma tendência de respostas insuficientes dos Entes Públicos. Assim, a sociedade não possui mais uma confiança no Estado e fica cada vez mais exigente e crítica, vendo as Instituições sobrecarregadas e sem crédito com relação a sua ética, cobrando que os Estados se reinventem, e isso só as tecnologias digitais podem resolver, possuindo rapidez e qualidade.

Posteriormente, a Revolução 4.0 e as Inteligências Artificiais foram melhor explicadas, para se entender como surgiram essas inovações e o que são, assim como o objetivo delas em na sociedade. Este novo cenário no mundo tem quebrado padrões e apresentado modelos disruptivos para potencializar as oportunidades e corrigir o tempo atual, momento no qual foi abordada a temática acerca do mundo que confunde a realidade com o antes imaginário. As IAs destacam-se por serem programas multidisciplinares que deram uma grande virada tecnológica no mundo do Direito, fazendo trabalhos repetitivos, predizendo casos, trazendo aceleração e eficiência para o sistema. A sua grande chave do sucesso é o equilíbrio entre elas e os princípios éticos.

Uma ferramenta utilizada pelo Poder Judiciário dos Estados Unidos foi analisada neste trabalho para que fossem vistas as duas faces das inovações digitais. O COMPAS é utilizado para auxiliar no cálculo da dosimetria da pena, a partir de um questionário que quantifica a chance de reincidência daquele réu, classificando-o de alto risco ou baixo risco. Com base em eventos passados, o sistema faz uma análise preditiva de cada caso. A intenção da ferramenta é clara e possui seus benefícios, como o de tornar as decisões mais justas e menos influenciáveis por erros humanos, além da celeridade processual.

Por outro lado, baseado na investigação da empresa jornalística ProPublica(2016), foi observado que o COMPAS possui vieses racistas e pode acabar expondo os preconceitos da própria sociedade, já que o sistema é alimentado com dados de decisões anteriores e, possivelmente, do íntimo dos programadores. Foi relatado que os réus negros tinham mais chances de receber pontuações mais altas do que os brancos. E, ainda, foi analisado que mesmo que os réus negros não reincidissem, continuariam tendo mais chances de serem classificados de forma divergente dos brancos, expondo os preconceitos raciais da IA.

Além do mais, os algoritmos dessa ferramenta possuem obscuridade por falta de transparência, impossibilitando a defesa do réu, que não saberá o porquê daquela pena e de sua classificação, e a fundamentação do juiz na sentença, o qual não conseguirá explicar como chegou naquele cálculo se for usar o sistema como base. Isto causa uma grande violação do princípio do devido processo constitucional. Mostrando que as soluções tecnológicas, se enviesadas e com ausência de claridade, podem intensificar o problema e não resolvê-lo.

Todavia, mesmo com essas tribulações, as soluções existem, e é preciso que tecnologias análogas, sem suas falhas, sejam implementadas no Poder Judiciário brasileiro, que está sobrecarregado. Visto que, uma boa programação poupa recursos públicos, garante um maior acesso à justiça, evita que o Direito se desvirtue, aumenta a produtividade e a eficiência, e assegura a dignidade das pessoas, afastando seus preconceitos e criando uma evolução moral na sociedade.

O Brasil possui muitos cases de sucesso quando se trata de inovações e processos inteligentes como as IAs, usando como exemplo as plataformas citadas que otimizam as gestões de processos, predizem resultados de decisões, criam peças processuais, reúnem jurisprudências, fazem escolhas de estratégias para negociações, auxiliam na fiscalização do controle externo, e até fazem análise do juiz do caso para que o advogado saiba quais argumentos utilizar. Então por que não criar uma Inteligência Artificial que ajude as decisões a serem mais éticas, céleres e que não gerem impunidades?

Consequentemente, foram analisadas formas para criar uma IA com um objetivo similar e maior que o do COMPAS, predizer o grau de reincidência de um réu, auxiliando os juízes na dosimetria da pena e até minutar uma sentença. Nesse contexto, uma plataforma desenvolvida com esses fins necessitaria de uma equipe de criação com pluralidade de conhecimentos, ou seja, de diversas áreas, com a formação de startups com esse intuito. Além de contar com a colaboração entre o Poder Público, as Universidades Federais e a iniciativa privada, para que se facilite o seu uso. Ainda é preciso que o sistema seja sempre treinado e fiscalizado com a intenção de não se afastar da realidade. Para que isto ocorra da maneira correta, os algoritmos utilizados no sistema devem ser transparentes, detalhados em um documento e publicizado para que, deste modo, seja reduzida a incompreensão dos seres humanos sobre os sistemas e os resultados gerados pelo sistema de IA.

Conclui-se então que, mesmo com algumas dificuldades enfrentadas, é possível e necessário que ferramentas com Inteligência Artificial venham (re)moldar o mundo jurídico, o qual ainda não utiliza de todas as tecnologias que estão ao seu alcance e se retraem por medo de alguns algoritmos, medo do desconhecido. No entanto, este fator não deve limitar, e sim fazer com que seja pensado com grandeza. Predizer um cometimento de um novo crime é evitá-lo, é um controle preventivo, um ideal pela diminuição de tantas violências sofridas, de um mundo já tão desgastado. Tirar do povo a imagem de que a justiça é lenta e “injusta”. (Re)criar cenários em que se possa viver em paz e confiança. Utopia? Não, o futuro.

REFERÊNCIAS

BRASIL. Lei n° 11.419 de dezembro de 2006. Dispõe sobre a informatização do processo judicial; altera a Lei nº 5.869, de 11 de janeiro de 1973 – Código de Processo Civil; e dá outras providências. Brasília – DF, 2006. Disponível em: <http://www.planalto.gov.br/ccivil_03/_ato2004-2006/2006/lei/l11419.htm> Acesso em 25 set. 2020;

CANÁRIO, Pedro. 37% dos réus submetidos a prisão provisória não são condenados à prisão. Consultor Jurídico. 2014;

EDELMAN BRASIL. Brasileiros estão mais confiantes nas instituições. 06 ABR. 2020. Disponível em: <https://www.edelman.com.br/estudos/edelman-trust-barometer-2020>Acesso em 29 out. 2020;

FELIPE, Bruno Farage da Costa; PERROTA, Raquel Pinto Coelho. INTELIGÊNCIA ARTIFICIAL NO DIREITO: Uma realidade a ser desbravada. Revista de Direito, Governança e Novas Tecnologias. v. 4, n. 1, p. 01-16.Salvador – BA. 2018. Disponível em: <https://www.indexlaw.org/index.php/revistadgnt/article/view/4136/pdf.> Acesso em: 06 out. 2020;

FUNDAÇÃO GETÚLIO VARGAS. ICJBrasil 2017: Confiança da população nas instituições cai. 24 out. 2017. Disponível em: <https://portal.fgv.br/noticias/icjbrasil-2017-confianca-populacao-instituicoes-cai> Acesso em 3 nov. 2020;

GANDOUR, Fábio. Podcast #8:A inteligência artificial vai pegar você!.MIT Sloan Review Brasil.14 ago. 2020. Disponível em: <https://www.mitsloanreview.com.br/podcasts/18-fabio-gandour-a-inteligencia-artificial-vai-pegar-voce> Acesso em 31 out. 2020;

HARARI, Yuval Noah. Homo Deus: Uma breve história do amanhã. Tradução de Paulo Geiger. São Paulo: Companhia das Letras, 2016;

HERMANN, M; PENTEK, T; OTTO, B. PRINCÍPIOS DO DESING PARA OS CENÁRIOS DA INDÚSTRIA 4.0: Uma literatura de revisão. Business Engineering Institute St. Gallen, Lukasstr. 4, CH-9008. St. Gallen, 2015;

HOUAISS, Antônio. Dicionário Houaiss da Língua Portuguesa. Rio de Janeiro: Objetiva. 2004;

ISRANI, ElloraThadaney. Quando um algoritmo ajuda a enviar você para a prisão. The New York Times. New York. 2017. Disponível em:<https://www.nytimes.com/2017/10/26/opinion/algorithm-compas-sentencing-bias.html>. Acesso em: 17 out. 2020;

KARNAL, Leandro. Karnal: utopias servem para melhorar a realidade. 2017. Disponível em: <https://www.youtube.com/watch?v=k4NMjMCEDyI> Acesso em 11 set. 2020;

LARSON, Jeff; MATTU, Surya; KIRCHNER, Lauren; ANGWIN, Julia. Como analisamos o algoritmo de reincidência COMPAS. Propublica, New York. 2016;

LÉVY, Pierre. A INTELIGÊNCIA COLETIVA: Por uma antropologia dociberespaço. São Paulo: Folha de S. Paulo, 2015;

LUMER, Christoph.Enciclopédia de Filosofia. Hamburg: Meiner. 2005;

MCGINNIS, John O.; PEARCE, Russell G. A GRANDE RUPTURA: como a máquina, a inteligência transformará o papel dos advogados na prestação de serviços jurídicos.Fordham Law Review. v. 17, n.14. 15 mai. 2014. New York. 2014;

MICKLETHWAIT, John; WOOLDRIDGE, Adrian. A QUARTA REVOLUÇÃO: A corrida global para reinventar o estado. São Paulo: Portfolio-Penguin. 2015;

NUNES, Dierle; MARQUES, Ana Luiza Pinto Coelho. INTELIGÊNCIA ARTIFICIAL E DIREITO PROCESSUAL: vieses algorítmicos e os riscos de atribuição de função decisória às máquinas. Revista dos Tribunais online. v. 285. 2018. Disponível em:<file:///C:/Users/tce/Downloads/INTELIGENCIA_ARTIFICIAL_E_DIREITO_PROCES%20(2).pdf.> Acesso em: 07 out. 2020;

O CAFEZINHO. A NOVA PESQUISA IBOPE MOSTRA RECUPERAÇÃO DE CONFIANÇA NAS INSTITUIÇÕES. 07 de ago. 2019. Disponível em: <https://www.ocafezinho.com/2019/08/07/a-nova-pesquisa-ibope-mostra-recuperacao-de-confianca-nas-instituicoes/> Acesso em 27 out. 2020;

PIAIA, Thami Covatti; COSTA, Bárbara Silva; WILLERS, Miriane Maria. QUARTA REVOLUÇÃO INDUSTRIAL E A PROTEÇÃO DO INDIVÍDUO NA SOCIEDADE DIGITAL: Desafios para o direito. Revista Paradigma. v. 28, n. 1, p. 122-140. Ribeirão Preto – SP. 2019;

RICHTER, André. Pesquisa do CNJ aponta 80 milhões de processos em tramitação no país. Agência Brasil. 27 ago. 2018. Disponível em: <https://agenciabrasil.ebc.com.br/justica/noticia/2018-08/pesquisa-do-cnj-aponta-80-milhoes-de-processos-em-tramitacao-no-pais> Acesso em 29 out. 2020;

SCHWAB, Klaus. A Quarta Revolução Industrial. São Paulo: EDIPRO, 2016;

SIMA, Alice. O que é predição e como ela está revolucionando o Direito? SAJ DIGITAL. 13 mar. 2019. Disponível em: <https://www.sajdigital.com/pesquisa-desenvolvimento/o-que-e-predicao/> Acesso em 7 out. 2020.

Notas de fim

[1] Discente do Curso de Direito do Centro Universitário de João Pessoa (UNIPÊ). E-mail: [email protected]; Orientador: Msc. Renan Do Valle Melo Marques. E-mail: [email protected].

[2] Perfil Corretivo de Gerenciamento de Infratores para Sanções Alternativas (tradução livre).

[3] Forças, Fraquezas, Oportunidades e Ameaças (tradução livre).

[4]A deusa da justiça na mitologia grega.

[5]Pessoas que se opõem às novas tecnologias. Termo vindo do movimento Ludita ocorrido na Inglaterra.

[6] É a rede de objetos físicos, sistemas, plataformas e aplicativos com tecnologia embarcada para comunicar, sentir ou interagir com ambientes internos e externos. Permite que as coisas interajam umas com outras e que tomada de decisões sejam feitas. A internet das coisas é a base da Indústria 4.0 (HERMANN, PENTEK, OTTO, 2015, p. 4.).

[7] É um processo de análise de interpretação de um grande volume de dados armazenados remotamente, podendo integrar qualquer dado coletado sobre um determinado assunto.

[8]Processamento de linguagem natural (tradução livre).

[9]Aprendizado de máquina, aprendizado profundo (tradução livre).

[10]Processamento de linguagem natural (tradução livre).

[11]Programa de estudos brasileiros (tradução livre).

[12]Laboratório jurídico de startups (tradução livre).

[13]Startup é uma empresa jovem com um modelo de negócios repetível e escalável, em um cenário de incertezas e soluções a serem desenvolvidas.